/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

/中文/

Todo清單v2.0.0官方版

Todo清單v2.0.0官方版 京東自動搶券v1.50免費版

京東自動搶券v1.50免費版 Everything官方版v1.4.1.998最新版

Everything官方版v1.4.1.998最新版 LOL英雄聯盟角色變大工具v1.0 綠色防封版

LOL英雄聯盟角色變大工具v1.0 綠色防封版 美圖秀秀64位最新版v6.4.2.0 官方版

美圖秀秀64位最新版v6.4.2.0 官方版 福昕pdf編輯器去水印綠色版(圖像處理) v9.2 最新版

福昕pdf編輯器去水印綠色版(圖像處理) v9.2 最新版 微軟必應詞典官方版(翻譯軟件) v3.5.4.1 綠色版

微軟必應詞典官方版(翻譯軟件) v3.5.4.1 綠色版 搜狗輸入法電腦最新版(輸入法) v9.3.0.2941 官方版

搜狗輸入法電腦最新版(輸入法) v9.3.0.2941 官方版 網易音樂(音樂) v2.5.5.197810 電腦版

網易音樂(音樂) v2.5.5.197810 電腦版  WPS Office 2019 電腦版(WPS Office ) 11.1.0.8919全能完整版

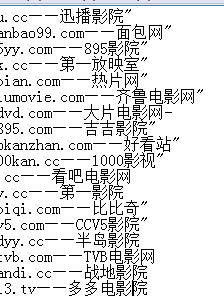

WPS Office 2019 電腦版(WPS Office ) 11.1.0.8919全能完整版Url采集(含站長擴展搜索)是一款關鍵詞url批量采集腳本,除開熱門的百度相關搜索詞采集,當然還有360搜索引擎以及搜狗搜索引擎,多線程關鍵詞采集URL,需要走代理,不然會出驗證。

先導入關鍵詞到key.txt文檔,在運行軟件

多線程搜索關鍵詞提取

Url采集是一個非常專業易用的關鍵詞url批量采集腳本,含站長擴展搜索,包括熱門的百度相關搜索詞、360搜索引擎、搜狗搜索引擎采集,提供多線程搜索關鍵詞提取,使用的時候隻需要先導入關鍵詞到key.txt文檔,在運行軟件,就可以批量采集關鍵詞url,非常簡單,網站優化必備小神器哦~

程序主要運用於安全滲透測試項目,以及批量評估各類CMS係統0DAY漏洞的影響程度,同時也是批量采集自己獲取感興趣的網站的一個小程序~~

測試環境為 Python 2.7.x 如果需要python3版本的,可以自行修改,或者我的博客留言

目前隻可以采集百度搜索引擎的結果。並且每頁默認顯示50條記錄。可自定義輸入要采集的頁數。

如果要采集關鍵詞為“hacker”的相關網站,采集百度結果的前3頁,則輸入如下:

please input keyword:hacker

Search Number of pages:3

1:Url采集工具獲取到的是百度搜索結果的真實URL地址

2:可以忽略不需要的常見網站,如忽略百度翻譯,等等所有百度相關結果,給數組添加baidu.com即可。程序已經默認忽略了很多條啦,如

filter_array1 = ['baidu.com','sina.com.cn','sohu.com','taobao.com','douban.com','163.com','tianya.cn','qq.com','1688.com']

filter_array2 = ['ganji.com','58.com','baixing.com']

filter_array3 = ['zhihu.com','weibo.com','iqiyi.com','kugou.com','51.com','youku.com','soku.com','acfun.cn','verycd.com']

filter_array4 = ['google.cn','youdao.com','iciba.com','cdict.net']

filter_array5 = ['pconline.com.cn','zcool.com.cn','csdn.net','lofter.com']

3:實時顯示采集到的網頁的【真實URL】以及【標題】。前麵的【ID】對應的是當前頁百度結果的第X條數據

4:自動保存結果到當前目錄的txt文件,文件名為搜索的 關鍵詞.txt 為了方便導入到其他工具,txt文件裏麵隻記錄了采集的網址。如果需要同時記錄標題,把代碼中的注釋刪除即可

5:自動去除重複記錄

6:統計總采集條數(143 found),有效的條數(91 checked),被過濾的條數(52 filter),以及被過濾的重複的URL條數(9 delete)

7:開源,任何人都可以下載使用。由於本人能力有限,如果有好的建議以及修改,也希望能一起完善

8:跨平台,並且無捆綁後門風險。以前網上有的百度URL采集軟件大部分為WINDOWS下的可執行文件,並且現在百度更新後無法正常采集。

9:程序會不斷更新

百度淘寶刷下拉快速優化排名神器(SEO優化工具) v6.7 特別版網絡輔助

/ 4.83M

百度淘寶刷下拉快速優化排名神器(SEO優化工具) v6.7 特別版網絡輔助

/ 4.83M

uninstall tool密鑰最新版網絡輔助

/ 1K

uninstall tool密鑰最新版網絡輔助

/ 1K

diskgenius離線激活碼永久版網絡輔助

/ 37M

diskgenius離線激活碼永久版網絡輔助

/ 37M

守望先鋒dva本子完整版(內含視頻) 高清網盤版網絡輔助

/ 1M

守望先鋒dva本子完整版(內含視頻) 高清網盤版網絡輔助

/ 1M

友邦微信群發軟件(微信推廣工具) v5.7 最新版網絡輔助

/ 27.84M

友邦微信群發軟件(微信推廣工具) v5.7 最新版網絡輔助

/ 27.84M

網頁自動點擊操作助手電腦版(自動刷網頁點擊數) v19.1.0 免費版網絡輔助

/ 8M

網頁自動點擊操作助手電腦版(自動刷網頁點擊數) v19.1.0 免費版網絡輔助

/ 8M

CDR注冊機(cdr永久激活代碼) 免費版網絡輔助

/ 323K

CDR注冊機(cdr永久激活代碼) 免費版網絡輔助

/ 323K

吉吉影音資源BT種子(吉吉影音看片網站) 免費版網絡輔助

/ 397K

吉吉影音資源BT種子(吉吉影音看片網站) 免費版網絡輔助

/ 397K

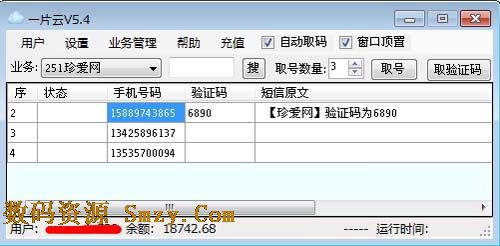

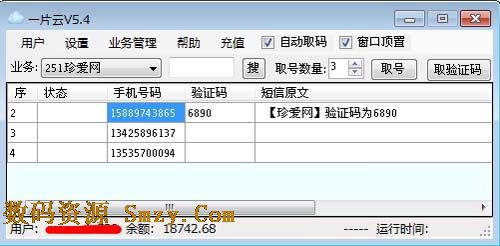

一片雲驗證碼平台(驗證碼接收工具) v6.4 官方最新版網絡輔助

/ 1004K

一片雲驗證碼平台(驗證碼接收工具) v6.4 官方最新版網絡輔助

/ 1004K

360種子在線編輯器(360種子洗白工具) v1.0.1 綠色免費版網絡輔助

/ 1M

360種子在線編輯器(360種子洗白工具) v1.0.1 綠色免費版網絡輔助

/ 1M

百度淘寶刷下拉快速優化排名神器(SEO優化工具) v6.7 特別版網絡輔助

/ 4.83M

百度淘寶刷下拉快速優化排名神器(SEO優化工具) v6.7 特別版網絡輔助

/ 4.83M

吉吉影音資源BT種子(吉吉影音看片網站) 免費版網絡輔助

/ 397K

吉吉影音資源BT種子(吉吉影音看片網站) 免費版網絡輔助

/ 397K

uninstall tool密鑰最新版網絡輔助

/ 1K

uninstall tool密鑰最新版網絡輔助

/ 1K

diskgenius離線激活碼永久版網絡輔助

/ 37M

diskgenius離線激活碼永久版網絡輔助

/ 37M

守望先鋒dva本子完整版(內含視頻) 高清網盤版網絡輔助

/ 1M

守望先鋒dva本子完整版(內含視頻) 高清網盤版網絡輔助

/ 1M

友邦微信群發軟件(微信推廣工具) v5.7 最新版網絡輔助

/ 27.84M

友邦微信群發軟件(微信推廣工具) v5.7 最新版網絡輔助

/ 27.84M

網頁自動點擊操作助手電腦版(自動刷網頁點擊數) v19.1.0 免費版網絡輔助

/ 8M

網頁自動點擊操作助手電腦版(自動刷網頁點擊數) v19.1.0 免費版網絡輔助

/ 8M

CDR注冊機(cdr永久激活代碼) 免費版網絡輔助

/ 323K

CDR注冊機(cdr永久激活代碼) 免費版網絡輔助

/ 323K

360種子在線編輯器(360種子洗白工具) v1.0.1 綠色免費版網絡輔助

/ 1M

360種子在線編輯器(360種子洗白工具) v1.0.1 綠色免費版網絡輔助

/ 1M

一片雲驗證碼平台(驗證碼接收工具) v6.4 官方最新版網絡輔助

/ 1004K

一片雲驗證碼平台(驗證碼接收工具) v6.4 官方最新版網絡輔助

/ 1004K